BUSINESS FOKUS

Big Data in der Lieferkette ermöglicht die Entwicklung innovativer Strategien, mit denen Unternehmen ihre Logistikabläufe verbessern können. Durch die Analyse aller in den Lagern erzeugten Daten, können Unternehmen Verbesserungsmöglichkeiten erkennen und strategische Geschäftsentscheidungen treffen.

Die Nutzung von mit dem Internet verbundenen Geräten hat sich in den letzten fünf Jahren vervielfacht. Eine Studie des Beratungsunternehmens International Data Corporation geht davon aus, dass 2025 weltweit mehr als 41 Milliarden intelligente Geräte existieren werden: Es wird erwartet, dass die Gesamtzahl der Geräte im selben Jahr eine Datenmenge von mehr als 79,4 Zettabytes erzeugen wird.

Das exponentielle Wachstum der generierten Datenmenge - auch bekannt als Big Data- bietet eine einzigartige Gelegenheit zur Verbesserung der Prozesse und Entscheidungsfindung in Unternehmen. Laut dem Technologieberatungsunternehmen Gartner, „sind Big Data große, schnelle oder variantenreiche Informationsbestände, die kosteneffiziente, innovative Methoden der Informationsverarbeitung erfordern, um ein besseres Verständnis, eine bessere Entscheidungsfindung und eine Prozessautomatisierung zu ermöglichen“.

Mit der Analyse von Big Data Datenmengen gewonnen. Für die Segmentierung und Umwandlung von Daten sind in letzter Zeit zahlreiche Big-Data-Technologien wie Cassandra, Integrate oder MongoDB eingeführt worden, die riesige Datenmengen sammeln und verarbeiten können, deren Analyse mit herkömmlichen Programmen nicht möglich wäre.

Die Technologie von Big Data wird heute in unterschiedlichsten Unternehmen und Bereichen eingesetzt, z. B. in Produktionsabteilungen zur Optimierung der Leistung oder im Marketing, zur Marktsegmentierung und zur Erzielung optimaler Ergebnisse.

Warum ist „Big Data“ für Unternehmen so wichtig?

Mit der Analyse von Big Data können Unternehmen die riesigen Datenmengen, die bei ihnen anfallen, überwachen und verarbeiten, um neue Chancen für das Unternehmen zu identifizieren.

Gemäß der Studie Big data analytics capabilities and knowledge management: impact on firm performance, „sorgt die Analyse von Big Data dafür, dass Daten analysiert, in nützliche Informationen für Unternehmen kategorisiert und in effiziente Entscheidungsprozesse umgewandelt werden können, um so die Leistung zu steigern”.

Und genau bei der Entscheidungsfindung in Unternehmen macht Big Data den Unterschied aus. Eine fachübergreifende Forschungsarbeit der Anderson School of Management (USA ) und des College of Economics and Management (China) bestätigt die strategische Rolle von Big Data in der Wirtschaft: „Unsere empirischen Ergebnisse zeigen, dass der Einsatz von Big-Data-Analysen sich positiv auf die Entscheidungsqualität auswirkt.“ Die Autoren der in der Fachzeitschrift Technological Forecasting and Social Change veröffentlichten Studie verweisen auf das Potenzial von Big-Data-Analysen zur Verbesserung der Konkurrenzfähigkeit von Unternehmen. „Unternehmen sollten nicht nur Big Data bei ihren Geschäftsaktivitäten verstärkt einsetzen, sondern auch ihre Kapazität zur Analyse dieser Daten ausbauen. Dadurch wird die Entscheidungsqualität verbessert und sie gewinnen einen entscheidenden Wettbewerbsvorteil.“

„Big Data“ in der Lieferkette

Big Data eröffnet den Führungskräften in der Lieferkette eine Fülle von Möglichkeiten. Laut einem Bericht von Ernest & Young planen 61 % der befragten Führungskräfte in den nächsten drei Jahren die Einführung von Analysen von Big Data, während 33 % der Befragten bereits Pilotprojekte durchführen oder Big-Data-Analysetools in einigen Bereichen ihrer Lieferkette implementiert haben.

Die Datenanalyse kann enorme Vorteile bei der Produktion, der Lagerung, dem Transport und dem Vertrieb von Waren bringen. In der akademischen Publikation „Big Data analytics in supply chain management“ der Wissenschaftler der Universität in Western Illinois (USA ) wird Folgendes festgestellt: „Die Analyse von Big Data im Lieferkettenmanagement bietet zahlreiche Vorteile, wie z. B. die bessere Vorhersage von Angebot und Nachfrage, die Analyse sich ändernder Kundenpräferenzen oder die verbesserte Transparenz der Lieferkette, stellt Unternehmen aber auch vor neue Herausforderungen.

Mit Big-Data-Tools werden Analysemethoden zur Unterstützung einer fundierten Entscheidungsfindung in der Lieferkette eingesetzt. „Die Analyse von Big Data hat sich als Mittel zur Erstellung von genaueren Vorhersagen erwiesen, die die Kundenbedürfnisse besser widerspiegeln, die Leistungsbewertung der Lieferkette erleichtern, die Effizienz steigern, die Reaktionszeit verkürzen und die Risikobewertung unterstützen“, erklären Forscher des Concordia Institute for Information Systems Engineering (Kanada).

Supply Chain Analytics: „Big Data“ für das Lagerwesen

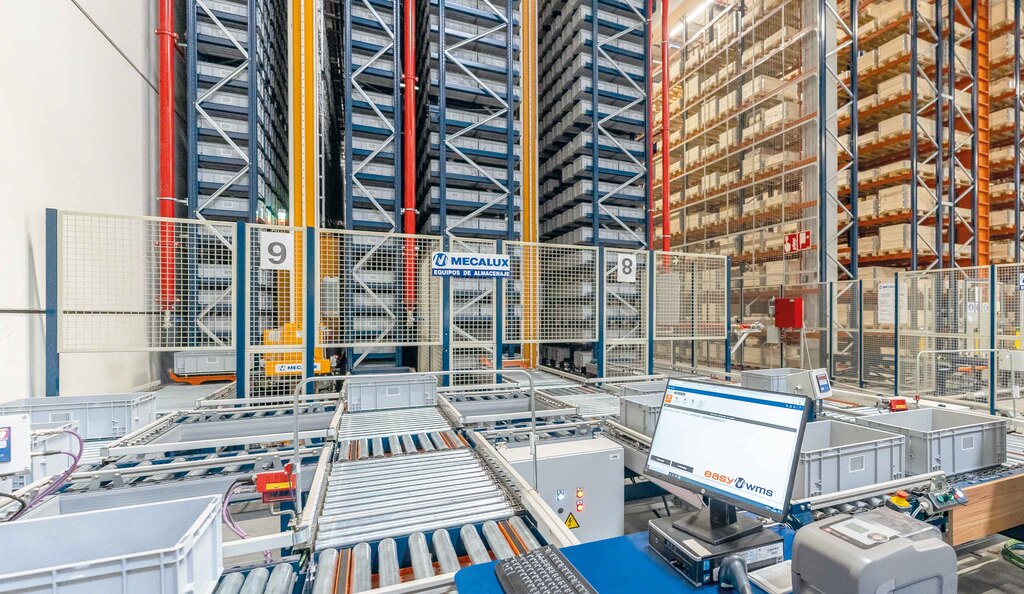

Die Digitalisierung in der Logistik fördert den Einsatz vernetzter Geräte, die eine Unmenge von Daten erzeugen. Zur Vereinfachung der Analyse und Interpretation hat Mecalux Supply Chain Analytics entwickelt, eine erweiterte Funktion der Lagerverwaltungssoftware Easy WMS, die die Daten aus beliebigen Anlagen segmentiert und strukturiert.

Durch die Umwandlung der riesigen Menge an Lagerdaten in nützliche Informationen kann der Logistikverantwortliche einfacher und genauer Entscheidungen treffen. Die Software zur Analyse der Lieferkette wandeltdie Daten in Kennzahlen um, die einen Überblick über die betriebliche Leistung in Echtzeit und eine historische Analyse der Leistung der Anlage bieten.

Die Software umfasst Bedienfelder und Diagramme mit grundlegenden Informationen über die Anlage, wie z. B. den Anteil der auf Lager befindlichen Artikel oder der vorbereiteten Produktionslinien. Das Programm erstellt außerdem an die Anforderungen der Logistikverantwortlichen anpassbare Leistungskennzahlen.

Supply Chain Analytics sorgt für eine flexible und produktive Logistik, die sich an die Bedürfnisse von Unternehmen anpassen lässt. Das Unternehmen Intermark, das Verpackungs- und Etikettierprodukte herstellt, hat z. B. sein Lager mit dem erweiterten Analysemodul von Mecalux ausgestattet, um eine lückenlose Rückverfolgung der Logistikvorgänge zu gewährleisten. „Das Modul verdeutlicht, wie die Prozesse ablaufen, und hilft uns, auf Grundlage der Leistung des täglichen Betriebs, strategische Verbesserungen einzuführen. Unser Markt ist sehr dynamisch und die Anforderungen der Kunden verändern sich schnell, weshalb wir gezwungen sind, unser Geschäft entsprechend den sich ändernden Kundenanforderungen umzugestalten. Wir verfügen mit diesem Modul nun über datenbasierte Informationen, um Änderungen zur Verbesserung unserer Logistik vorzuschlagen“, erklärt Sergi Jané von der technischen Abteilung von Intermark.

Die Analyse von Big Data liefert Unternehmen auch zuverlässige und objektive Daten, um Prozesse zu ändern und zu optimieren. „Easy WMS passt hervorragend zu den Besonderheiten unseres Unternehmens. „Mit diesem System erhalten wir Informationen über die Verfügbarkeit der Artikelarten und können eine Inventur in Echtzeit durchführen“, erläutert James Hansen, stellvertretender Geschäftsführer von Yamazen in den USA. Der Werkzeugmaschinenhändler verwendet das Modul Supply Chain Analytics, um die Leistung der Abläufe im Lager abzurufen und zu analysieren.

Mecalux hat das Modul Supply Chain Analytics in Logistikanlagen weltweit und für Unternehmen aus verschiedenen Branchen implementiert. Unternehmen setzen mit dieser Technologie Big Data in ihren Lagern ein, um alle Vorgänge in der Lieferkette zu überwachen.

Die Macht der Daten bringt die Logistik voran

Die Analyse von Big Data ist in allen Branchen sinnvoll, aber in der Logistikbranche ist sie unerlässlich. Die riesige Menge an in Lagern erzeugten Daten birgt ein enormes Potenzial zur Unterstützung der strategischen Entscheidungsfindung.

Die Unternehmen verlassen sich auf Technologien, um die riesigen Datenmengen zu interpretieren, die täglich in den verschiedenen Bereichen des Unternehmens anfallen. Die Analyse von Big Data eröffnet neue Möglichkeiten für Verbesserungen, wie z. B. die Optimierung von logistischen Abläufen, die Planung zukünftiger Investitionen oder die Einführung neuer Produkte oder Projekte.

„Big Data“: eine Revolution im Aufwind

1997 stellten die NASA-Forscher Michael Cox und David Ellsworth das Konzept von Big Data in dem Artikel „Application-controlled demand paging for out-of-core visualization“ vor. „Die Prozessvisualisierung ist eine spannende Herausforderung für Computersysteme: Die Datensätze sind oft groß und strapazieren die Kapazität des Hauptspeichers, der lokalen Festplatte und sogar der externen Festplatte. Wir nennen dies das Problem der großen Datenmengen (Big Data).“

Anfang der 2000er Jahre eröffnete das „Internet für Jedermann“ einzigartige Möglichkeiten für die Sammlung und Analyse von Daten. Durch die Ausweitung der Online-Verkaufsportale wurde es für Unternehmen wie eBay oder Amazon einfacher, sich auf die Analyse des Kundenverhaltens zu konzentrieren, um die Verkaufszahlen zu steigern. Später verstärkte das Aufkommen sozialer Netzwerke den Bedarf an Tools zur Organisation der gewaltigen Menge an unstrukturierten Daten, die aus dem Internet stammen. Mit der Einführung des Internets der Dinge (IoT) und des Machine Learning hat die Nutzung von vernetzten Geräten jedoch zugenommen und die Möglichkeiten von Big Data um ein Vielfaches erhöht.

Zwar haben sich Big-Data-Analysetools bereits bewährt, doch das Aufkommen neuer Technologien wie Cloud Computing eröffnet neue Wege, um das Potenzial der Datenanalyse zu nutzen und die Unternehmensleistung zu optimieren.

Die 5 Schlüsselfaktoren des „Big Data“

Big Data umfasst fünf Dimensionen, die 5 Schlüsselfaktoren darstellen:

- Volumen: Die riesige Menge an Informationen aus zahlreichen Quellen muss durch neue fortschrittliche Methoden der Datenverwaltung, -verwertung und -speicherung verwaltet werden.

- Geschwindigkeit: Der massive und konstante Datenfluss in einem rasanten Tempo erfordert flexible Tools für die Erfassung und Verarbeitung, damit die gesammelten und analysierten Informationen nicht obsolet werden.

- Vielfalt: Big-Data-Analysetools müssen nicht nur schriftliche Quellen verarbeiten, sie müssen auch Bilder, Computerdaten, Audiodateien, Videos sowie alle Arten von Inhalten auf sozialen Medien und neuen Plattformen verarbeiten.

- Richtigkeit: Bei der Analyse von Big Data geht es um die Auswahl korrekter Daten für die weitere Analyse und das Aussortieren irrelevanter Informationen.

- Wert: Wurden die gesammelten Daten richtig ausgewählt und analysiert, sind die gewonnenen Informationen für das Unternehmen äußerst wertvoll.